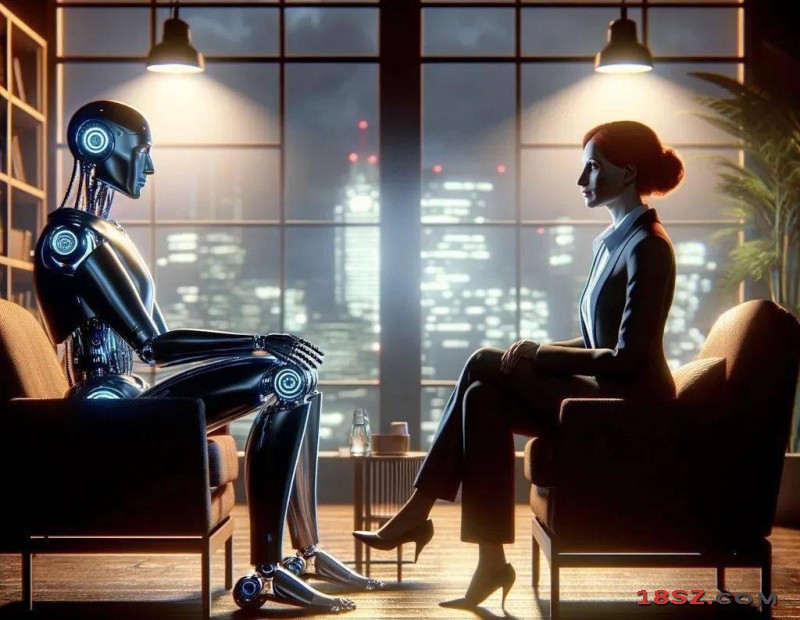

美国最大的心理学家协会近日向联邦监管机构发出警告,指出某些人工智能聊天机器人假扮为心理治疗师,但其编程方式倾向于强化用户的固有想法,而非挑战他们的认知,这可能使脆弱人群面临自我伤害或伤害他人的风险。

《纽约时报》报道,美国心理学会(APA)首席执行长埃文斯(Arthur C. Evans Jr.)在联邦贸易委员会(FTA)的一次会议上,提到了两个令人震惊的案例。这些案件涉及青少年在对话型人工智能平台Character.AI上与伪装成“心理学家”的虚拟角色进行交流的经历。Character.AI允许用户创建虚拟AI角色或与他人创建的角色互动的平台。

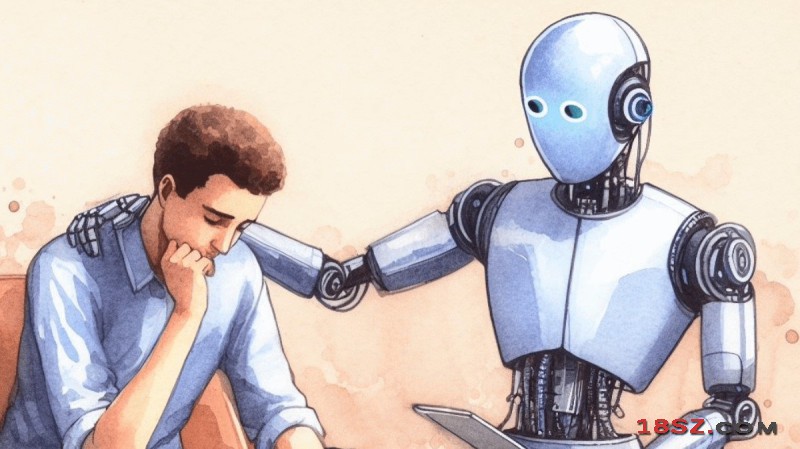

在第一个案例中,一名来自佛罗里达州的14岁男孩在与一个自称为执业心理治疗师的AI角色互动后选择结束生命。第二个案例中,一名17岁的得克萨斯州自闭症男孩在与AI聊天机器人沟通期间,对父母表现出敌对和暴力行为。两名少年的家属均已对相关公司提起诉讼。

埃文斯说,AI机器人提供的回应令人震惊,它们未能在用户产生危险念头时挑战其认知,反而进一步强化了这些思维。他补充说,若人类心理治疗师提供同样建议,或将失去执业资格甚至面临法律责任。

“这些机器人使用的算法实际上违背了受过训练的临床医生的做法……我们担心越来越多的人会因此受到伤害。他们会被误导,并对良好的心理护理产生错误理解。”

他指出,AI聊天机器人的输出内容变得愈发逼真,是促使APA采取行动的重要原因。“也许10年前,人们很容易看出自己在与非真人互动,但今天并非如此……所以我认为,现在的风险要高得多。”

尽管这些AI平台的初衷是为了娱乐,但“心理治疗师”和“心理学家”角色却大量涌现。这些虚拟角色通常声称拥有名校学位(如斯坦福大学)和特定心理治疗的专业训练,例如认知行为疗法(CBT)或接纳与承诺疗法(ACT)。

Character.AI的发言人则说,公司过去一年已推出多项新的安全措施。

Iteca Exhibitions

Iteca Exhibitions 长城润滑油

长城润滑油 German Machine Tool Builders Association

German Machine Tool Builders Association 延长石油

延长石油 3M制造业

3M制造业 陕煤化工集团

陕煤化工集团 Dahua Technology

Dahua Technology HUAWEI

HUAWEI 中国石油

中国石油 Gemtique

Gemtique KUNVII

KUNVII IAA Show

IAA Show PALEXPO

PALEXPO LASTON

LASTON 陕西有色金属

陕西有色金属 QIIE青岛进博会

QIIE青岛进博会 中杭贸易

中杭贸易 Etek Europe

Etek Europe PV EXPO

PV EXPO 维远光伏产业

维远光伏产业 Time Out Group

Time Out Group IFEMA

IFEMA 天元化工

天元化工 National Media

National Media 吉祥星科技

吉祥星科技 海康威视-HIK VISION

海康威视-HIK VISION Hannover Messe

Hannover Messe Dowpol Chemical

Dowpol Chemical TOSHIBA

TOSHIBA Productronica

Productronica HealthCare

HealthCare 深圳会展中心

深圳会展中心 大唐旗舰店

大唐旗舰店 Soul Game

Soul Game 神木职教中心

神木职教中心 MFV Expositions

MFV Expositions 2023 NAB Show Centennial

2023 NAB Show Centennial 上海8K原创纪录片《玉兰之城》

上海8K原创纪录片《玉兰之城》 坐着高铁看中国 十月一日出发

坐着高铁看中国 十月一日出发 新一代军用大型运输机 运-20 鲲鹏宣传片

新一代军用大型运输机 运-20 鲲鹏宣传片 深圳时装周首日上演东西方文化的强烈碰撞

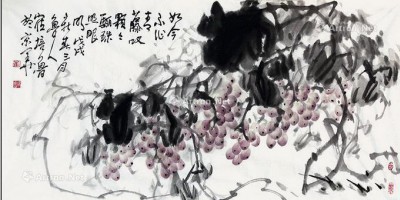

深圳时装周首日上演东西方文化的强烈碰撞 崔培鲁画牡丹花

崔培鲁画牡丹花 花边水晶桌旗V型摆件

花边水晶桌旗V型摆件 鲁芳斋艺术展厅送出五福临门

鲁芳斋艺术展厅送出五福临门 新一届欧盟委员会召开第一次会议

新一届欧盟委员会召开第一次会议 2019年纽伦堡欧洲国际啤酒、酿酒设备及饮料设备技术展览会

2019年纽伦堡欧洲国际啤酒、酿酒设备及饮料设备技术展览会 迷你火车展上的微缩纽约

迷你火车展上的微缩纽约 拜登与贺锦丽就任美国第46任总统与副总统

拜登与贺锦丽就任美国第46任总统与副总统 青白釉系印花卉纹双兽钮执壶

青白釉系印花卉纹双兽钮执壶 德国柏林解除社交限制措施

德国柏林解除社交限制措施 Exhibit at Valve World Expo

Exhibit at Valve World Expo 崔培鲁国画香港2018年拍卖记录

崔培鲁国画香港2018年拍卖记录 自主可控国产碳化硅SiC MOSFET单管及模块

自主可控国产碳化硅SiC MOSFET单管及模块 个人艺术黄金展预约

个人艺术黄金展预约 2024第13届深圳国际营养与健康产业博览会

2024第13届深圳国际营养与健康产业博览会 Skater No. 4(布上丙烯)

Skater No. 4(布上丙烯) 2023年中欧塑料工业展览会 Fakuma

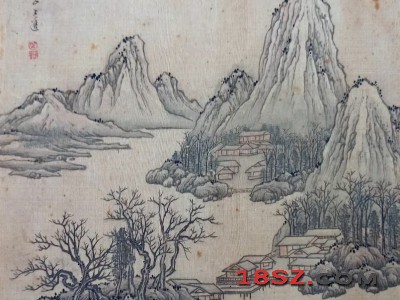

2023年中欧塑料工业展览会 Fakuma 国画微湖鸟石图

国画微湖鸟石图 海南报关行|海口港报关行

海南报关行|海口港报关行 2022上海医疗器械展览会

2022上海医疗器械展览会 意大利里米尼城市介绍

意大利里米尼城市介绍 纽伦堡 - 玩具都城

纽伦堡 - 玩具都城 慕尼黑 - 伊萨尔河畔的酒都

慕尼黑 - 伊萨尔河畔的酒都 法兰克福 - 欧洲金融中心

法兰克福 - 欧洲金融中心 迪拜 - Dubal

迪拜 - Dubal 俄罗斯 - 战斗民族和套娃的国家

俄罗斯 - 战斗民族和套娃的国家 葡萄牙 - 软木塞之乡

葡萄牙 - 软木塞之乡 西班牙 - 斗牛士的故乡

西班牙 - 斗牛士的故乡